欧盟立法者支持生成性人工智能的透明度和安全规则

今天和大家分享的是一篇追踪欧盟AI法案立法的外媒报道。

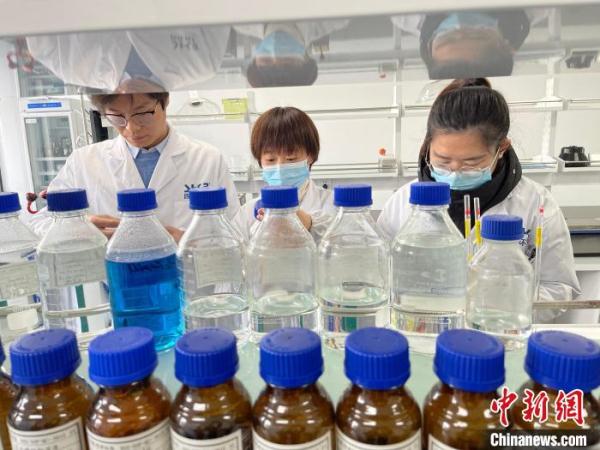

【资料图】

【资料图】

在今天早晨的一系列欧洲议会投票中,议员们支持了对该集团草拟的AI立法的一系列修订案,包括对所谓的基础模型的一套要求,这些模型支撑着OpenAI的ChatGPT等生成性AI技术。

由两个委员会的议员们达成一致的修订案文本,要求基础模型的提供者在将其模型投放市场之前,应用安全检查,数据治理措施和风险缓解措施,包括要求他们考虑“对健康、安全、基本权利、环境以及民主和法治的可预见风险”。

修订案还承诺基础模型制作者将减少其系统的能源消耗和资源使用,并在即将由AI法案建立的欧盟数据库中注册他们的系统。而生成性AI技术的提供者(如ChatGPT)有义务遵守法规中的透明度义务(确保用户被告知内容是由机器生成的);在他们的系统生成的内容中应用“适当的保护措施”;并提供一个关于用于训练他们的AI的任何受版权保护的材料的摘要。

近几周,议员们一直专注于确保通用目的的AI不会逃避监管要求,我们之前已经报道过。

议会议员争论的其他关键领域包括生物特征监测——在这里,议员们也同意了旨在加强基本权利保护的改变。

立法者们正在努力达成议会对AI法案的谈判授权,以解锁欧盟共同立法过程的下一阶段。

两个委员会的议员,内部市场委员会和公民自由委员会,今天对大约3,000个修订案进行了投票,通过了关于计划中的人工智能规则手册的草案授权,赞成票84票,反对票7票,弃权票12票。

“在对委员会提案的修订中,议员们的目标是确保AI系统由人类监督,安全、透明、可追溯、无歧视性,并且环保。他们还希望有一个统一的,旨在对技术中立的AI定义,以便它可以适用于今天和明天的AI系统,”议会在新闻发布中说。

今天由各委员会达成一致的关键修订案包括扩大禁止行为的清单,增加了对AI系统的“侵入性”和“歧视性”使用的禁令,例如:

在公共可接触的空间使用“实时”远程生物识别系统;

“后置”远程生物识别系统,唯一的例外是执法机构为了起诉严重罪行并且仅在司法授权后;

使用敏感特性(如性别,种族,种族,公民身份,宗教,政治取向)的生物特征分类系统;

基于个人资料,位置或过去的犯罪行为的预测性警务系统;

在执法,边境管理,工作场所和教育机构中的情绪识别系统;以及

从社交媒体或闭路电视录像中无差别抓取生物识别数据以创建面部识别数据库(侵犯人权和隐私权)。

后者,即完全禁止美国有争议的AI公司Clearview AI的商业模式,正好在法国数据保护监察机构因其未能遵守现有的欧盟法律而再次对该初创公司进行罚款的一天后。因此,对选择无视该集团规则的外国实体执行此类禁令无疑将仍然是一个挑战。但第一步是有硬性法律。

在投票后发表声明的共同报告人和议员Dragos Tudorache补充说:

鉴于AI将对我们的社会和经济产生深远的变革性影响,AI法案很可能是这个任期中最重要的立法。这是全球首个此类立法,这意味着欧盟可以引领将AI人本化,值得信赖和安全的道路。我们一直致力于支持欧洲的AI创新,并为初创公司,中小企业和行业提供成长和创新的空间,同时保护基本权利,加强民主监督,并确保成熟的AI治理和执行系统。

预计下个月(在6月12日至15日的会议期间),议会将进行全体投票以确定授权,之后将与理事会开始三方对话,以达成关于该文件的最终妥协。

在2021年,当欧盟委员会提出其AI法案草案建议时,它认为基于风险的框架将为“人本化”和“值得信赖”的AI创建一份蓝图。然而,人们很快就提出了担忧,认为该计划远未达标——包括与生物识别监控相关的领域,因为委员会只建议在公共场所对使用高度侵入性技术如面部识别的使用进行有限的禁止。

民间社会团体和欧盟机构呼吁进行修订以增强对基本权利的保护——欧洲数据保护监察员和欧洲数据保护委员会等机构呼吁该立法进一步发展,并敦促欧盟立法者在公共场所全面禁止生物特征监控。

欧洲议会议员似乎在很大程度上注意到了民间社会的呼吁。尽管仍存在担忧。(当然,还有待观察,随着各成员国政府在未来几个月内参与谈判,欧洲议会议员如何加强的提议可能会被再次削弱。)

议员在今天的委员会投票中同意的其他变动包括扩展法规的(固定)“高风险”领域的分类——包括对人们的健康,安全,基本权利和环境的危害。

在政治竞选中用于影响选民的AI系统以及大型社交媒体平台(拥有超过4500万用户,与数字服务法案中的VLOPs分类相符)使用的推荐系统也被列入高风险名单。

同时,议员们也支持改变什么算作高风险——建议让AI开发者决定他们的系统是否足够重要以满足适用义务的标准,这是数字权利团体警告(见下文)的“主要红旗”。

在其他地方,议员们支持旨在提高公民关于AI系统的投诉权和接收基于高风险AI系统对其权利产生“显著”影响的决策解释的修订。

缺乏对受有害AI影响的个体有意义的救济是民间社会团体在2021年秋季对修订的重大呼吁中提出的一个主要漏洞,他们指出了委员会的AI法案提案和该集团的通用数据保护法之间的显著差异,根据后者,个人可以向监管机构投诉并寻求其他形式的救济。

议员们今天同意的另一项变动是对被称为欧盟AI办公室的机构的角色进行改革,他们希望该机构监控规则手册是如何执行的 - 以补充对成员国级别的法规的分散式监督。

同时,为了回应永恒的行业哭诉,即过多的监管对“创新”有害,他们还为研究活动和提供开源许可证的AI组件增加了规则的豁免权,同时指出法律促进了由公共机构建立的监管沙盒,或受控环境,以测试AI的部署前的表现。

数字权利团体EDRi,一直在敦促对委员会草案进行重大修订,表示议员们通过的所有修订都以“某种形式或另一种形式”通过 - 特别是在公共场所对面部识别的(现在)全面禁止;以及对预测警察,情绪识别和AI的其他有害用途的(新)禁止。

它指出的另一个关键胜利是对部署高风险AI的责任和透明度义务的包含 - 他们有义务进行基本权利影响评估以及受影响的人们可以挑战AI系统的机制。

“议会通过其禁止清单向政府和AI开发者发送了明确的信息,顺应了民间社会的要求,即AI的某些用途对于被允许而言太有害了,” EDRi的高级政策顾问Sarah Chander告诉TechCrunch。

“这份新文本比委员会原始提案在控制我们的面部,身体和身份的敏感数据的滥用方面要好得多,”另一位专注于生物识别的EDRi高级政策顾问Ella Jakubowska补充道。

然而,EDRi表示仍存在关注的领域 - 将AI用于移民控制为一个大问题。

对此,Chander指出,议员未能将AI用于促进“非法推回”,或以歧视性方式对人进行分档的做法列入禁止的实践列表 - 这是EDRi曾经呼吁的。“不幸的是,[欧洲议会]对人民权利的支持并未阻止移民免受AI带来的伤害,包括AI用于推动推回的情况," 她说,并建议:“没有这些禁止,欧洲议会正在为在欧盟边界开设全景监控系统打开大门。”

该团体表示,它还希望看到对预测警察禁令的改进 - 覆盖基于位置的预测警察,Chander将其描述为“本质上是一种自动化种族判别”。她表示,该团体担心,提议的远程生物识别禁令不会覆盖欧洲各地正在使用的大规模监视实践的全部范围。

“尽管议会在生物识别方面的做法非常全面,但我们希望看到的是进一步限制一些实践。尽管有对公共面部识别的回顾性禁令,但法律执法部门仍然有例外,我们认为这仍然存在风险。尤其是,它可能激励大规模保留CCTV录像和生物识别数据,这是我们明确反对的,”Jakubowska补充说,并表示该团体还希望看到无论情境如何,欧盟都会禁止情绪识别 - “因为这种‘技术’从根本上来说是有缺陷的,不科学的,而且设计上就是歧视的”。

EDRi提出的另一个关注点是议员们建议让AI开发者判断他们的系统是否高风险 - 这可能会破坏可执行性。

“不幸的是,议会提出了一些非常令人担忧的变化,这些变化与什么算作‘高风险AI’有关。随着文本中的变化,开发者将能够决定他们的系统是否‘足够重要’以被视为高风险,这对于执行这项立法来说是一个主要的红旗,”Chander建议。

虽然今天的委员会投票是向设定议会授权的大步,也为即将与理事会进行的三方对话设定了基调,但很多事情仍可能发生变化,并且可能会有来自成员国政府的一些反弹,他们往往更关注国家安全问题,而非关心基本权利。

当被问及是否期待理事会试图解开对生物识别监控扩大保护的一些问题时,Jakubowska表示:“我们可以从去年理事会的总体立场看出,他们希望淡化委员会原始文本中已经不足的保护。尽管没有可靠的有效性证据,但有大量的证据证明其有害,我们看到很多成员国政府都热衷于保留进行生物识别大规模监控的能力。

“他们经常以‘国家安全’为借口,例如在法国奥运会和残奥会的情况下,和/或作为将移民和其他边缘化社区刑事化的更广泛趋势的一部分。话虽如此,我们看到了可能被视为‘异议意见’的奥地利和德国,他们都倾向于在AI法案中加强生物识别数据的保护。我们还听说有几个其他国家愿意在生物识别条款的方向上做出妥协。这让我们有希望从三方对话中得到积极的结果,尽管我们当然预计会有几个成员国强烈反对。”

从公民社会给出的另一项早期评估中,爱尔兰公民自由理事会(ICCL)的高级研究员Kris Shrishak,该理事会也参加了2021年对AI法案进行重大修改的呼吁,他也对执行挑战提出了警告,他警告说,尽管议会通过明确允许监管机构进行远程检查的修订案加强了可执行性,但他认为,议会同时阻止了监管机构在调查中访问AI系统的源代码。

“我们也担心我们将看到类似GDPR的执行问题的重现,”他告诉TechCrunch。

在积极的一面,他表示,议会已经向解决欧盟委员会对AI系统定义的“不足”迈出了一步,特别是将生成性AI系统纳入范围,并对其实施透明度义务,他称这是“解决其危害的关键一步”。

但是,在版权和AI训练数据的问题上,Shrishak对议会未能坚决阻止数据挖掘巨头免费获取信息(包括版权保护的数据)的立场表示了批评。

版权修订案只要求公司提供用于训练的版权保护数据的摘要——这似乎意味着将让权利持有人去起诉。

当被问及可能担心研究活动和AI组件在开源许可下的豁免可能为AI巨头创造新的漏洞以逃避规则时,他表示这是一个担忧。

“研究是一个从法规范围内遗留下来的漏洞。这可能会被公司利用,”他建议说。“在AI的背景下,这是一个大漏洞,因为大部分研究正在公司中进行。我们已经看到谷歌说他们正在与Bard‘实验’。此外,我预计有些公司会声称他们开发AI组件而不是AI系统(我已经在关于通用AI的讨论中从一个大公司那里听到过这个。这是他们为什么GPAI[通用AI]不应该被监管的论点之一)。”

然而,欧洲自由软件基金会辩称,一个限制开源豁免只对“微型企业”有效的条款意味着,科技巨头在实践中很难将其作为一个漏洞来使用。

该基金会的高级政策顾问Alexander Sander告诉TechCrunch:“大科技公司将一切外包给微型企业而不再部署它们的可能性极小。一旦他们部署,他们再次落入法规之下(如果大于微型企业)。”

“实际上,我们通过这个决定保护了开发者,将责任转移给那些在市场上显著受益的部署者,”他还建议。

他补充说,该组织对议会的提议总体上感到满意,尽管批评了一些“超级复杂的措辞”,以及该规定仅被包含在一项序言(即而不是一篇文章)中。

他说,该团体也欢迎围绕“微型企业间活动”的更清晰的措辞,因为他们希望这也包括非营利性和微型企业间的活动。

关键词:

精心推荐

- 去年京津冀工信部门推进签约570多项高端高新项目

- 京津冀区域协同创新指数增长迅速

- 1至2月河北省工业生产平稳开局 规模以上工业增加值同比增长6.0%

- 浙江绍兴15日0-21时新增41例确诊病例

- 沈阳大气优良天数达近5年来最好水平

- 辽宁实行市级政府集中监管 首站定点冷库加强疫情防控

- 辽宁省25个博士后团队冲刺全国博士后创新创业大赛

- 安徽省宿州市埇桥区大营镇大营新村调整为中风险地区

- 云南哀牢山4名地质调查人员因公殉职原因查明

- 全国首部涉及“非现场执法”的法规施行 浦东新区打造引领区数字化城市治理样板

- 杭州一封控小区完成第三轮核酸检测 前两轮检测均为阴性

- 集采未中选药品现在怎么样了?这组数据告诉你

- “海归”博士后王暾:专注灾害预警科技创新 打通灾害预警“最后一公里”

- 福建宣判一起涉恶案件 10人犯罪团伙强迫交易、非法采矿获刑

-

中新网郑州12月15日电 (记者 韩章云)针对近日网友实名举报中国农业发展银行太康县支行员工夏某华吃空饷一事,中国农业发展银行河南省

-

中新网宿迁12月15日电 (记者 刘林)“房子干净又敞亮,社区漂亮又整洁。”15日,家住江苏宿迁牛角淹社区的袁有亮谈起新家,兴奋的心情

-

中新网通辽12月15日电 (记者 张林虎)15日,记者从内蒙古自治区通辽市科左后旗公安局获悉,该局打掉一个帮助网络犯罪转账的“跑分团队

-

中新网安徽阜阳12月15日电 ( 成展鹏)12月15日,规划占地面积2500亩、投资总额75亿元的安徽省阜阳市太和县保兴医药健康产业园内一片繁

-

中新网杭州12月15日电 (郭其钰 张益聪)从焦虑不安到互帮互助,浙江省杭州市上城区凯旋街道新城市广场B座里的257人经历了难忘的72小时

X 关闭

X 关闭

产业

-

不用跑北京 在家门口也能挂上顶...

日前,我省首个神经疾病会诊中心——首都医科大学宣武医院河北医院...

-

“十四五”期间 河北省将优化快...

从省邮政管理局获悉,十四五期间,我省将优化快递空间布局,着力构...

-

张家口市宣化区:光伏发电站赋能...

3月19日拍摄的张家口市宣化区春光乡曹庄子村光伏发电站。张家口市宣...

-

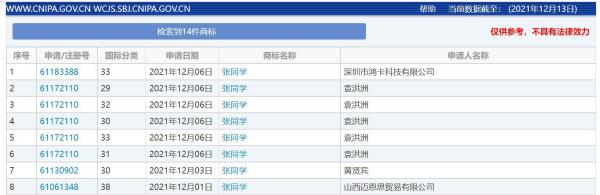

“张同学”商标被多方抢注 涉及...

“张同学”商标被多方抢注,官方曾点名批评恶意抢注“丁真” ...

-

山东济南“防诈奶奶团”花式反诈...

中新网济南12月15日电 (李明芮)“老有所为 无私奉献 志愿服...

-

广州新增1例境外输入关联无症状...

广州卫健委今日通报,2021年12月15日,在对入境转运专班工作人...

-

西安报告初筛阳性病例转为确诊病例

12月15日10:20,经陕西西安市级专家组会诊,西安市报告新冠病毒...

-

广东东莞新增本土确诊病例2例 ...

(抗击新冠肺炎)广东东莞新增本土确诊病例2例 全市全员核酸检测...

-

中缅边境临沧:民警深夜出击捣毁...

中新网临沧12月15日电 (胡波 邱珺珲)记者15日从云南临沧边境...

-

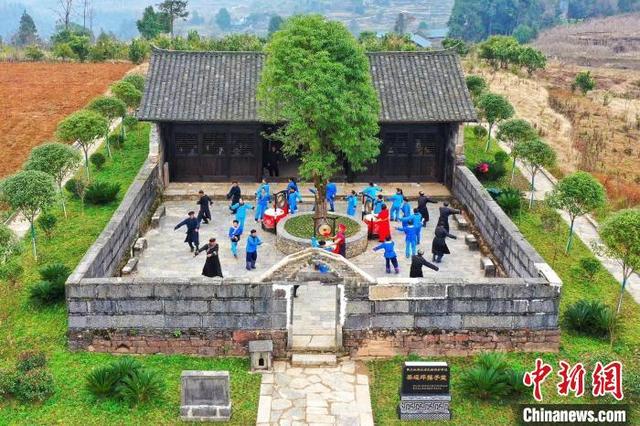

“土家鼓王”彭承金:致力传承土...

中新网恩施12月15日电 题:“土家鼓王”彭承金:致力传承土家...